スーパーコンピュータ「不老」紹介

- スーパーコンピュータ「不老」

- その他の機器

- 2020年6月まで運用していた機器

- SGI UV2000 (2020年7月以降しばらくの間はデータアクセスのみ可能)

- SX40 GPUサーバ

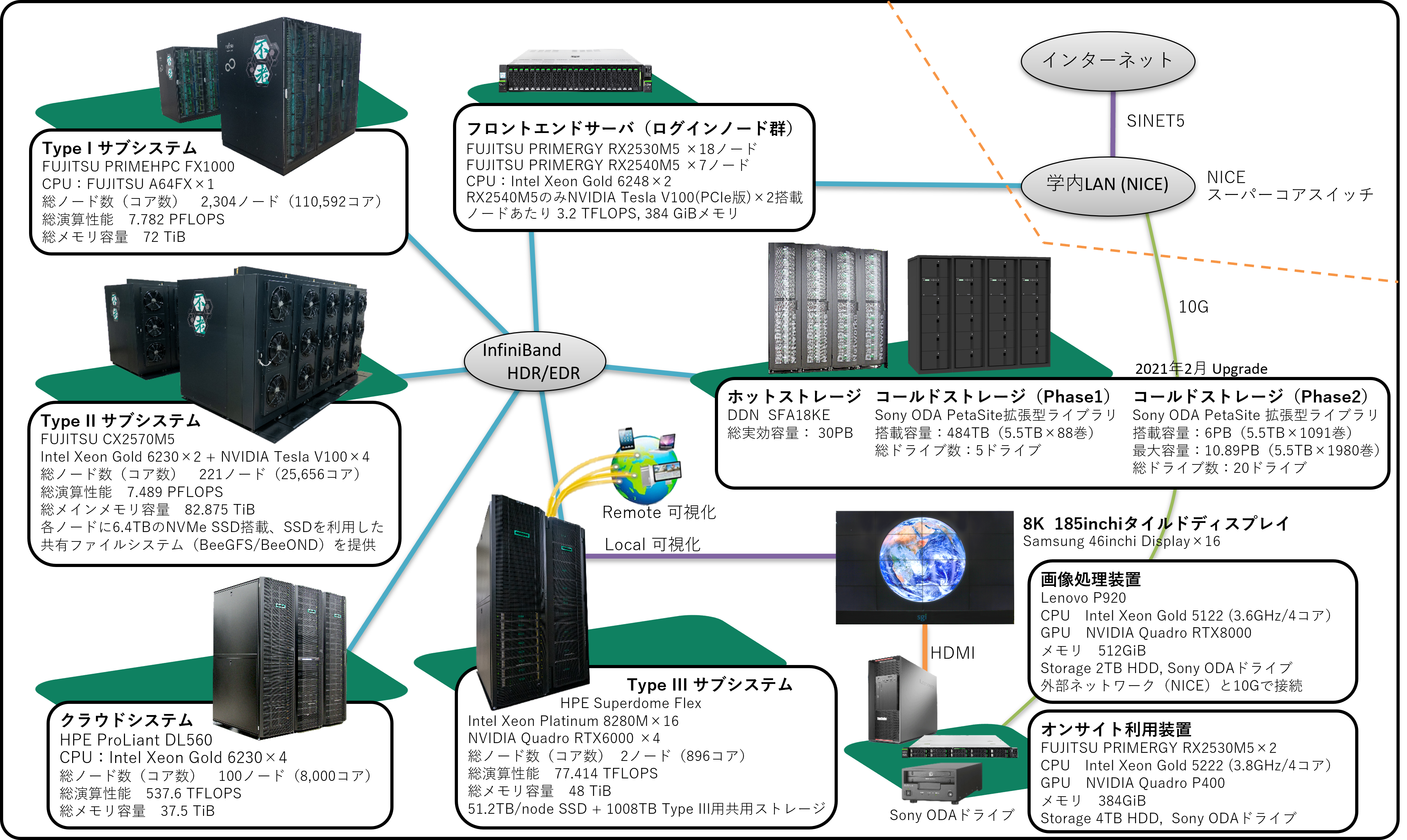

スーパーコンピュータ「不老」 全体構成

概要

スーパーコンピュータ「不老」は、特徴と役割の異なる4つの主要な計算サブシステム、2種類のストレージ、ログインノード群、および周辺装置群により構成されています。 従来のシステム(FX100のみで3.2PFLOPS、総合計4PFLOPS弱)と比べて大きく性能が向上しています。

「不老」の愛称は、コンピュータ用語の「フロー」と名古屋大学の所在地名である「不老町」に由来し、 このシステムによって人類が得ることができた恩恵がその後末永く人類の文明の中に生き続けることを願って名付けられました。 (参考:次期スーパーコンピュータの導入を決定!愛称は「不老(フロー)」)

全体構成図

全体性能

| 総理論演算性能 | 15.88PFLOPS (Type I 7.782PFLOPS, Type II 7.489PFLOPS, Type III 77.414TFLOPS, クラウド 537.6TFLOPS) |

| 総主記憶容量 | 240.375TiB (Type I 72.0TiB, Type II 82.875TiB, Type III 48.0TiB, クラウド 37.5TiB) |

| 計算ノード間インターコネクト | InfiniBand HDR/EDR (Type I内部はTofuインターコネクトD, 他サブシステム内部はEDR, サブシステム間はHDR) |

| 共有ストレージ容量 | ホットストレージ 30PB, コールドストレージ 6PB (Phase1では484TB) |

Type I サブシステム

特徴

理化学研究所 計算科学研究センター(RIKEN R-CCS)に設置が進められているスーパーコンピュータ「富岳」と同型の計算ノードにより構成されたシステムであるため、 FX100、「京」、「富岳」向けに開発されたプログラムが高速に実行できることが期待されます。 また他のサブシステムと比べてノード数が非常に多いため、多くのノードを用いた大規模分散並列実行に適しています。

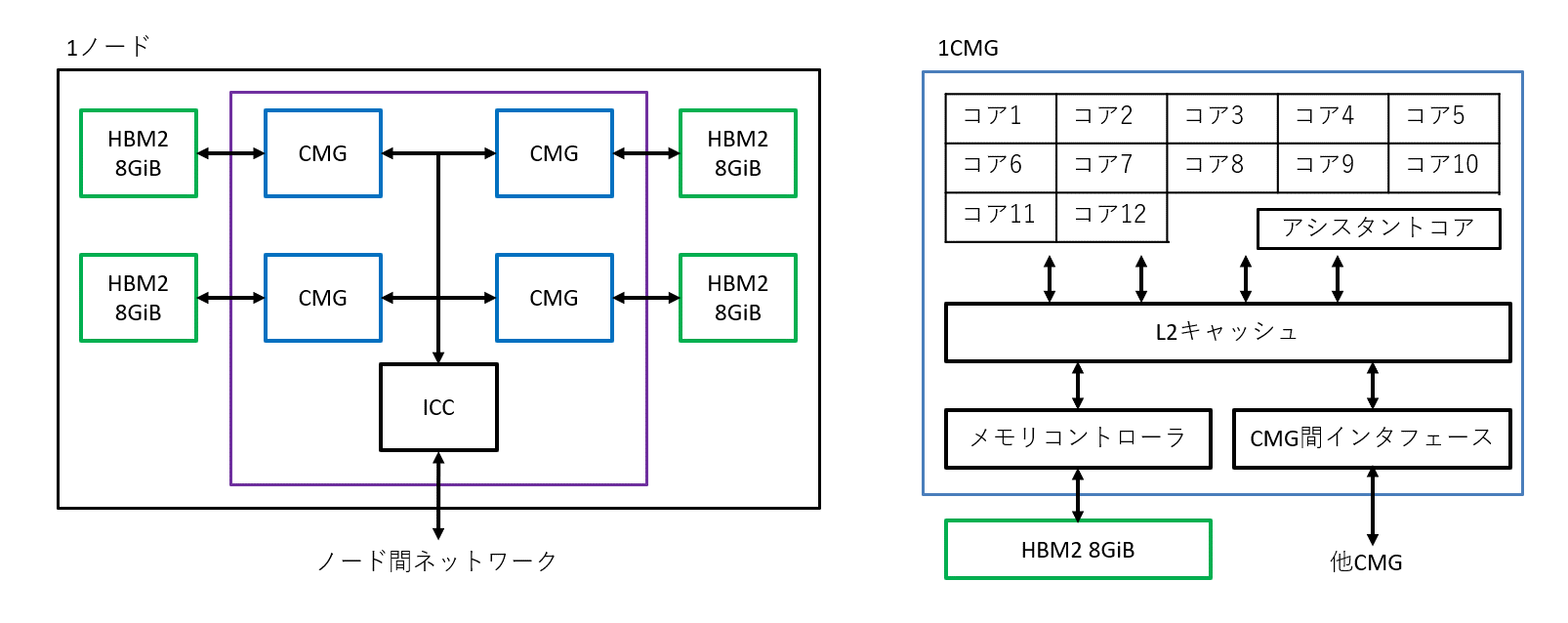

ハードウェア構成

| 機種名 | FUJITSU Supercomputer PRIMEHPC FX1000 | |

| 計算ノード | CPU | A64FX (Armv8.2-A + SVE), 48コア+2アシスタントコア(I/O兼計算ノードは48コア+4アシスタントコア), 2.2GHz |

| メインメモリ | HBM2, 32GiB | |

| 理論演算性能 | 倍精度 3.3792 TFLOPS, 単精度 6.7584 TFLOPS, 半精度 13.5168 TFLOPS | |

| メモリバンド幅 | 1,024 GB/s (1CMG=12コアあたり 256 GB/s, 1CPU=4CMG) | |

| ノード数、総コア数 | 2,304ノード、110,592コア(+4,800アシスタントコア) | |

| 総理論演算性能 | 7.782 PFLOPS | |

| 総メインメモリ容量 | 72 TiB | |

| ノード間インターコネクト | TofuインターコネクトD (各ノードは周囲の隣接ノードへ同時に合計 40.8 GB/s × 双方向 で通信が可能(1リンク当たり 6.8 GB/s × 双方向、6リンク同時通信可能)) | |

| ユーザ用ローカルストレージ | なし | |

| 冷却方式 | 水冷 | |

ノード内構成概要図

Type II サブシステム

特徴

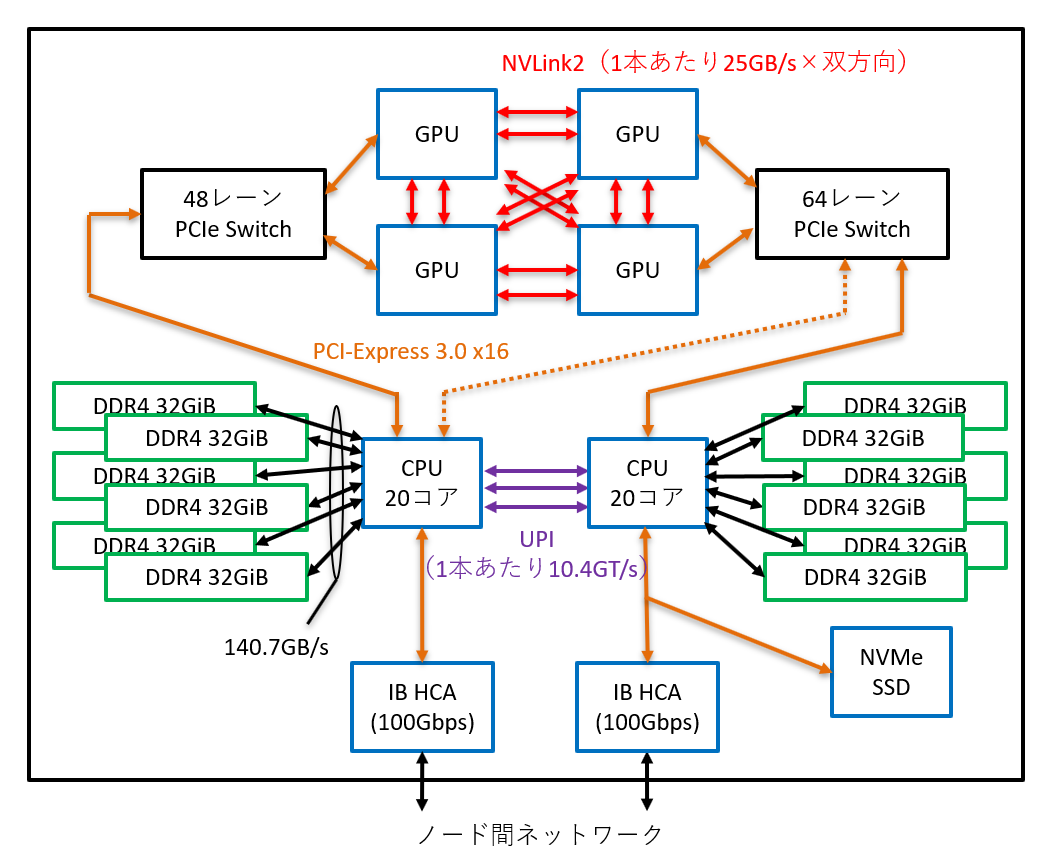

Intel社のCPUとNVIDIA社のGPUを搭載した汎用システムであるため、オープンソースソフトウェアなどのプログラムを持ち込んで実行するのに適しています。 最新の高性能計算向けGPUを1ノードあたり4枚搭載しているため、機械学習・AI・データ科学プログラムを実行するのに適しています。 I/O処理を高速化するため各ノードにNVMe接続のSSDを搭載しており、SSDを用いて共有ファイルシステムを作るBeeGFS/BeeONDも利用可能です。

ハードウェア構成

| 機種名 | FUJITSU Server PRIMERGY CX2570 M5 | |

| 計算ノード | CPU | Intel Xeon Gold 6230, 20コア, 2.10 - 3.90 GHz × 2 ソケット |

| GPU | NVIDIA Tesla V100 (Volta) SXM2, 2,560 FP64コア, upto 1,530 MHz × 4 ソケット | |

| メモリ | メインメモリ(DDR4 2933 MHz) 384 GiB (32 GiB × 6 枚 × 2 ソケット) デバイスメモリ(HBM2) 32 GiB × 4 ソケット |

|

| 理論演算性能 | 倍精度 33.888 TFLOPS (CPU 1.344 TFLOPS × 2 ソケット, GPU 7.8 TFLOPS × 4 ソケット) | |

| メモリバンド幅 | メインメモリ 281.5 GB/s (23.464 GB/s × 6 枚(6チャネル) × 2 ソケット) デバイスメモリ 900 GB/s × 4 ソケット |

|

| GPU間接続 | NVLINK2 (1GPUから他の3GPUに対してそれぞれ50GB/s×双方向) | |

| CPU-GPU間接続 | PCI-Express 3.0 (x16) | |

| ノード数、総コア数 | 221 ノード、8,840 CPUコア + 2,263,040 FP64 GPUコア | |

| 総理論演算性能 | 7.489 PFLOPS (CPU 0.594 PFLOPS, GPU 6.895 PFLOPS) | |

| AI-FLOPS(Tensor Flops) | ノード当たり:125TFLOPS X 4 = 500TFLOPS システム全体:125TFLOPS X 884 = 110.5PFLOPS |

|

| 総メモリ容量 | メインメモリ 82.875 TiB, デバイスメモリ 28.288 TiB | |

| ノード間インターコネクト | InfiniBand EDR 100 Gbps × 2, 200 Gbps | |

| ユーザ用ローカルストレージ | 各ノードにNVMe SSD 6.4TB, 一部ノードにて BeeGFS/BeeOND/NVMesh(ローカルストレージを使用した共有ファイルシステム)を提供 | |

| 冷却方式 | 水冷 | |

ノード内構成概要図

(64レーンPCIe Switchからは両CPUソケットに対して物理的な接続がありますが、BIOSレベルで排他的に選択して利用する必要があります。実際の利用シナリオを検討した結果、実線側の接続を選択しています。)

Type III サブシステム

特徴

- 2ノードで構成され、1ノードを会話型処理専用、もう1ノードをバッチ処理専用として運用します。

- 1ノードあたり24TiBという非常に大容量のメインメモリと、高性能な画像処理向けGPUを搭載しているため、大規模なプリ・ポスト処理や可視化処理に適しています。

- 会話型処理専用ノードが情報基盤センター1Fの可視化室に設置されている185インチ8K高精細ディスプレイと接続されているため、高品位やプリポスト処理やコンテンツ生成に利用できます。(高並列レンダリングに対応した可視化ソフトが利用できます。)

- NICE DCVを用いたリモート可視化が行えます。(インストール済のリモート可視化・可視化ソフトウェア一覧)

ハードウェア構成

| 機種名 | HPE Superdome Flex | |

| 計算ノード | CPU | Intel Xeon Platinum 8280M, 28コア, 2.70 - 4.00 GHz × 16 ソケット |

| GPU | NVIDIA Quadro RTX6000 × 4 | |

| メモリ | メインメモリ(DDR4 2933 MHz) 24 TiB (128 GiB × 192枚(12枚 × 16ソケット)) デバイスメモリ(GDDR6) 24 GiB × 4 |

|

| 理論演算性能 | 倍精度 38.7072 TFLOPS (CPU 2.4192 TFLOPS × 16 ソケット) | |

| メモリバンド幅 | メインメモリ 2252.544 GB/s (23.464 GB/s × 12枚(6チャネル) × 16ソケット) | |

| CPU-GPU間接続 | PCI-Express 3.0 (x16) | |

| ノード数 | 2 | |

| 総理論演算性能 | 77.414 TFLOPS (38.7072 TFLOPS × 2 ノード) | |

| 総メインメモリ容量 | 48 TiB | |

| ノード間インターコネクト | InfiniBand EDR 100 Gbps | |

| ユーザ用ローカルストレージ | 各ノードに504TBの外部接続ローカルストレージ 会話型ノードに102.4TB(6.4TB×16)のNVMe SSD |

|

| 冷却方式 | 空冷 | |

クラウドシステム

特徴(使い方)

Type I,II,III同様のバッチジョブ実行に加えて、時刻を指定してのジョブ実行やインタラクティブ実行ができます。 空冷、多ソケット、共有ジョブ実行が多い(複数のユーザのジョブが同じ時刻に同じノードに割り当たる実行形態になりやすい)ため 計算性能のばらつきが発生しやすい点には注意が必要ですが、 Type I,II,IIIでなかなかジョブが流れない場合や、 インタラクティブ実行を行いたい場合、時刻を指定してジョブを実行したい場合に活用してください。

- 実行形態と対応する実行方法

- バッチジョブ実行

- TypeI,II,IIIのサブシステム同様に、ログインノードからジョブを投入します。

- 時刻指定バッチジョブ実行

- 実行開始時刻を指定してのバッチジョブ実行です。バッチジョブスクリプトを用意したうえで、HPCポータルからジョブを投入します。

- 時刻指定インタラクティブ実行

- 指定した時刻になるとインタラクティブ実行可能になります。HPCポータルから実行予約を行います。

- バッチジョブ実行

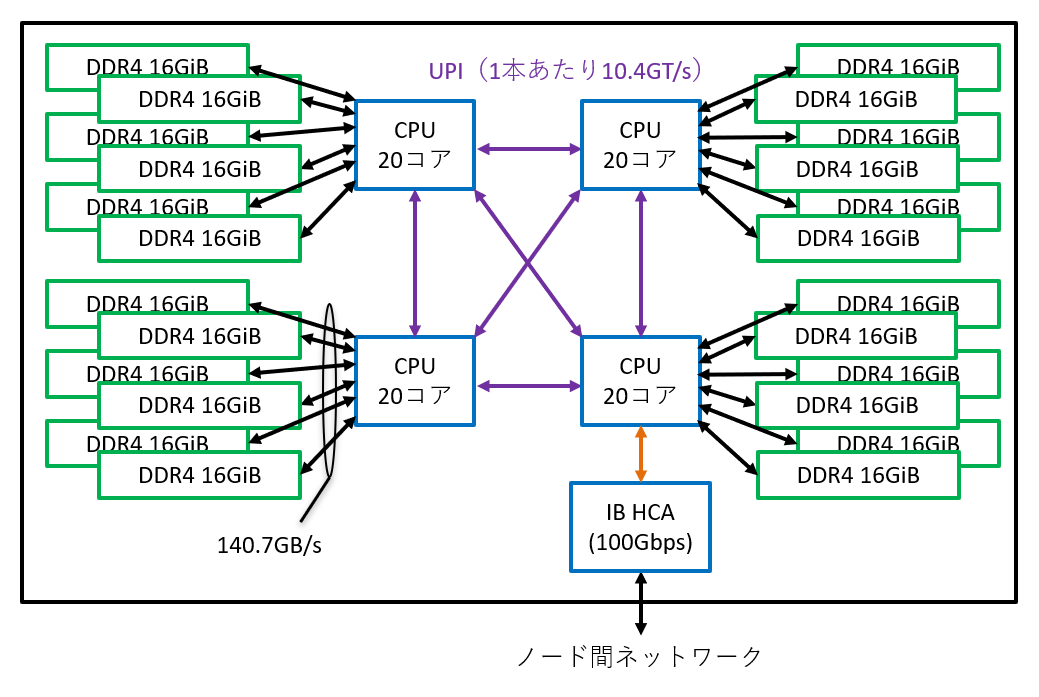

ハードウェア構成

| 機種名 | HPE ProLiant DL560 | |

| 計算ノード | CPU | Intel Xeon Gold 6230, 20コア, 2.10 - 3.90 GHz × 4 ソケット |

| メモリ | メインメモリ(DDR4 2933 MHz) 384 GiB (16 GiB × 6 枚 × 4 ソケット) | |

| 理論演算性能 | 倍精度 5.376 TFLOPS (1.344 TFLOPS × 4 ソケット) | |

| メモリバンド幅 | メインメモリ 563.136 GB/s (23.464 GB/s × 6枚(6チャネル) × 4 ソケット) | |

| ノード数 | 100 | |

| 総理論演算性能 | 537.6 TFLOPS (5.376 TFLOPS × 100 ノード) | |

| 総メインメモリ容量 | 37.5 TiB | |

| ノード間インターコネクト | InfiniBand EDR 100 Gbps | |

| ユーザ用ローカルストレージ | なし | |

| 冷却方式 | 空冷 | |

ノード内構成概要図

ログインノード群

ハードウェア構成

| 機種名 | FUJITSU PRIMERGY RX2530 M5/RX2540 M5 | |

| 計算ノード | CPU | Intel Xeon Gold 6248, 20コア, 2.50 - 3.90 GHz × 2 ソケット |

| GPU | NVIDIA Tesla V100 PCI-Express版 × 2 (TypeII用ログインノード群のみ) | |

| メモリ | メインメモリ(DDR4 2933 MHz) 384 GiB (32 GiB × 6 枚 × 2 ソケット) | |

| ノード間インターコネクト | InfiniBand EDR 100 Gbps | |

| ユーザ用ローカルストレージ | なし (コールドストレージ制御用ノードのみ19.2TBのSSDを搭載) | |

| 冷却方式 | 空冷 | |

ホットストレージ

特徴

ホットストレージは、各サブシステムおよびログインノードから共通にアクセス可能な共有ストレージです。

RAID6により保護されていますが、バックアップはとっていません。 不慮の事故や天災の際にはデータが完全に失われることがありますので、 再計算(再生産)不可能なデータを置く場合などには各自でバックアップを取るよう気を付けてください。

ハードウェア構成

| メタデータサーバ(MDS) | |

|---|---|

| 機種名 | FUJITSU PRIMERGY RX2540 M5 |

| CPU | Intel Xeon Gold 5222 (3.80GHz, 4コア) × 2 |

| メインメモリ | DDR4 192 GiB |

| HDD | SAS 900 GB 10krpm × 2 (RAID1) |

| Interconnect | InfiniBand EDR × 2 |

| SAN | FibreChannel 32 Gbps &tiems; 2 |

| OS | RedHat Enterprise Linux |

| ノード数 | 4台 |

| メタデータストレージサーバ(MDT) | |

| 機種名 | FUJITSU ETERNUS AF250 S2 |

| SSD | RAID1+0 [4D+4M] × 2 + 2HS RAID1+0 [3D+3M] × 1 + 2HS |

| ノード数 | 1台 |

| データストレージ(OSS/OST) | |

| 機種名 | DDN SFA18KE × 1台 DDN SS9012 × 10 台 |

| HDD | NL-SAS 14TB 7.2krpm × 730 RAID6 [8D+2P] 30 Device × 24 DCR Pool + 10HS |

| Interconnect | InfiniBand EDR × 8 |

| 搭載セット数 | 4 |

| 総容量 | |

| 物理容量 | 40.32 PB (Global Spareを除く) |

| 実効容量 | 約30.44PB |

コールドストレージ

特徴

大容量のデータを長期にわたって保存したいという需要に対応するため、Sony社製 Optical Disc Archive (ODA)を用いたコールドストレージ装置を提供します。 ODAは追記のみ可能な光ディスクストレージを用いるため、利用時には光ディスク代+管理費用を支払っていただきます。 スーパーコンピュータ「不老」のサービス終了時には利用した光ディスクが利用者の手元に残るため、 サービス終了後もディスク読み書き装置を用意すればお手元でデータをご利用いただけます。 光ディスクを持ち込んで利用する(管理費用のみの支払いとなります)ことも可能です。

- 利用案内

- Sony社による紹介動画:Introduction of PetaSite Library Systems/ Optical Disc Archive (Generation 3)(別ウィンドウで開きます)

ハードウェア構成

フェーズ1: 2020年7月1日より稼働開始

| 機種名 | PetaSite 拡張型 Library |

| カートリッジ数(総カートリッジ数/最大搭載可能カートリッジ数) | 88巻 / 88巻 |

| 総物理容量 / 最大搭載可能容量 | 484 TB / 484 TB |

| 総ドライブ数 | 6 |

フェーズ2: 2021年2月1日より稼働開始

| 機種名 | PetaSite 拡張型 Library |

| カートリッジ数(総カートリッジ数/最大搭載可能カートリッジ数) | 1,092巻 / 1,980巻 |

| 総物理容量/ 最大搭載可能容量 | 6 PB / 10.89 PB |

| 総ドライブ数 | 20 |

画像処理装置

特徴

- 対話型のプリ・ポスト処理やスーパーコンピュータシステムとの大容量ファイルのやりとりをしたい利用者のために、Windows10が動作するデスクトップパソコン(1台)を用意しています。

- 10Gbpsの高速ネットワークによるインターネット接続が可能です。

- USB外付けHDDや光ディスクメディア(Blue-rayディスク)を持ち込んでホットストレージに対するデータの読み書きを行うことができます。

- ODA単体ドライブが接続されているため、コールドストレージのアーカイブカートリッジに対するデータの読み書きも可能です。

- 情報基盤センター1Fの可視化室に設置されている185インチ8K高精細ディスプレイ接続されているため、大規模データの高品位なプリポスト処理やコンテンツ生成に利用できます。

- 利用を希望する場合は共同利用担当までお問い合わせください。

ハードウェア構成

| 機種名 | Lenovo ThinkStation P920 |

| CPU | Intel Xeon Gold 5122, 4コア, 3.60 - 3.70 GHz |

| GPU | NVIDIA Quadro RTX8000 |

| メモリ | メインメモリ(DDR4 2666 MHz) 512 GiB デバイスメモリ(GDDR6) 48 GiB |

| ユーザ用ローカルストレージ | 2 TB SSD |

| 光ディスクドライブ | ODS-D380U (5.5TB光ディスク・アーカイブカートリッジ対応) × 1 Blu-ray Disc対応ハイパーマルチドライブ装置 × 1 |

| 冷却方式 | 空冷 |

オンサイト利用装置

特徴

- 対話型のプリ・ポスト処理やスーパーコンピュータシステムとの大容量ファイルのやりとりをしたい利用者のために、Linuxが動作する計算サーバ(2台)を用意しています。

- 10Gbpsの高速ネットワークによるインターネット接続が可能です。

- USB外付けHDDや光ディスクメディア(Blue-rayディスク)を持ち込んでホットストレージに対するデータの読み書きを行うことができます。

- ODA単体ドライブが接続されているため、コールドストレージのアーカイブカートリッジに対するデータの読み書きも可能です。

- 利用を希望する場合は共同利用担当までお問い合わせください。

ハードウェア構成

| 機種名 | FUJITSU PRIMERGY RX2530 M5 |

| CPU | Intel Xeon Gold 5222, 4コア, 3.80 - 3.90 GHz |

| GPU | NVIDIA Quadro P400 |

| メモリ | メインメモリ(DDR4 2933 MHz) 384 GiB デバイスメモリ(GDDR5) 2 GiB |

| ノード数 | 2 |

| ユーザ用ローカルストレージ | 1ノードあたり1.6 TB SSD |

| 光ディスクドライブ | 各ノードに対して ODS-D380U (5.5TB光ディスク・アーカイブカートリッジ対応) × 1 Blu-ray Disc対応ハイパーマルチドライブ装置 × 1 |

| 冷却方式 | 空冷 |

その他の機器

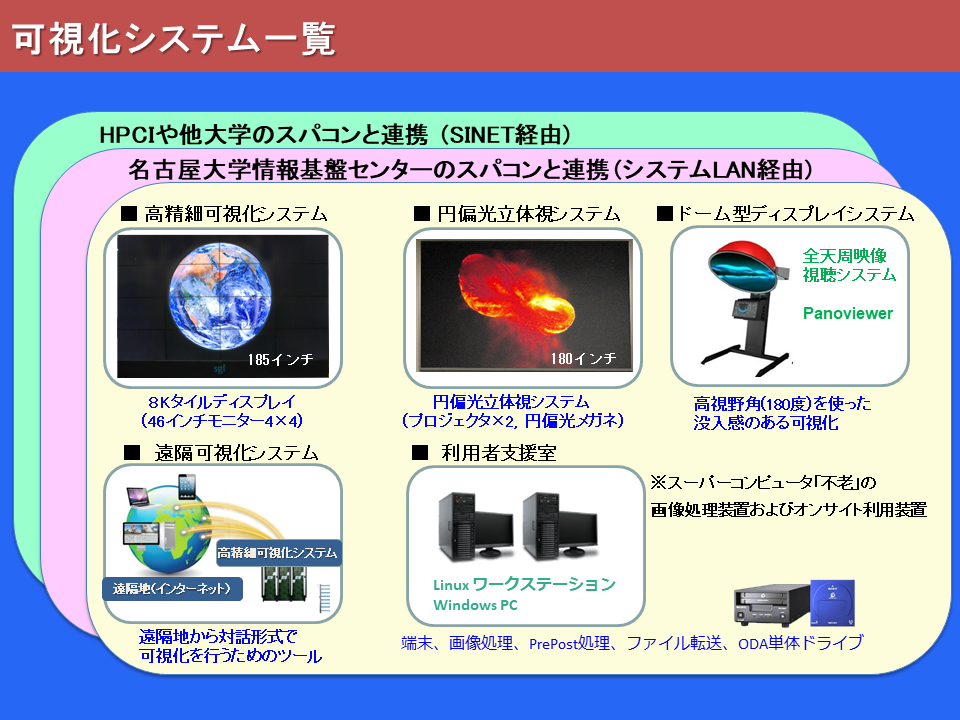

可視化システム

詳細は可視化システムをご覧ください。

2020年6月まで運用していた機器

SGI UV2000

UV2000の運用は2020年6月末までを予定しています。(7月以降、しばらくの間はデータへのアクセスのみ可能となります。)

ハードウェア構成

| 機種名 | SGI UV2000 |

| プロセッサ | Intel Xeon E5-4650 (2.40-3.30 GHz, 8 コア) |

| 総CPU数(総コア数) | 64 CPU (512 コア) |

| 総演算性能 | 9.6 TFLOPS |

| 総メモリ容量 | 8 TiB |

ソフトウェア構成

| OS | SuSE Linux Enterprise Server |

| 開発環境 | Intel Composer XE |

| MPI通信ライブラリ | SGI MPT |

| 数値計算ライブラリ | Intel MKL |

| フーリエ変換ライブ | PBS Professional |

| フーリエ変換ライブラリ | FFTW |

| 入出力ライブラリ | HDF5, NetCDF |

| 可視化ソフトウェア | AVS/Express Dev, AVS/Express PCE(並列版), EnSight DR, IDL, ENVI, ParaView, ffmpeg, ffplay, osgviewer, vmd(Visual Molecular Dynamics) |

| 遠隔可視化ソフトウェア | SGI NICE DCV |

| レイトレーシングソフトウェア | POV-Ray (SMP対応版) |

SX40 GPUサーバ

詳細はこちら